Du suchst einen echten KI-Videogenerator? Du willst ein KI-Video generieren und dabei faul auf dem Sofa liegen?

Kurze Antwort: Gibt’s noch nicht in “Production Ready” Qualität.

Lange Antwort: Es gibt sowas Ähnliches, was für dich eventuell nutzbar ist, und zwar

- Video-Generatoren für KI-Video-Avatare

- Stock-Footage-Video-Zusammenbasteltools und

- Post-Production-Template-Tools1

- KI-Videogeneratoren für kurze Sequenzen, wie der AI Video Generator2 für Amazon Ads (da werden Fotos “zum Leben erweckt”) oder die Luma Dream Machine oder Kling AI (da genügt ein Prompt) oder Runway (dazu gleich mehr). Urheberrechte? Reden wir nicht drüber. Bei Runway könnte das besser werden, da es einen Trainingsdaten-Deal mit den Lionsgate-Filmstudios gibt.

In diesem Artikel findest du einen kleinen Testbericht zu Runway, Oxolo und HeyGen (KI-Video-Avatare), InVideo AI und Invideo Studio (Aus-Stock-Footage-Video-Erstell-Programm) und Canva & Adobe Express (nur Schnitt und Post Production). Speziell InVideo Studio solltest du im Auge behalten. Akool.com erwähne ich nur hier und ganz kurz (bei Video-Avataren mit Voice Clone ist das ziemlich gut!). Weiter unten gibt es ein InVideo-Beispielvideo.

Über den Autor

Stefan Golling, Köln. Seit 2011 Freelance Creative Director, freier Texter, Creative Consultant und Online-Marketing-Berater mit Kunden von Mittelstand bis S&P 500. Erfahrung: 1998 mit Radiowerbung in Stuttgart gestartet, 2000 als Junior-Werbetexter zu Publicis München, 2001 Counterpart Köln, 2002 als Copywriter zu Red Cell Düsseldorf (heißt heute Scholz & Friends), dort ab 2007 Creative Director.

Inhalt

Was ist ein KI-Videogenerator?

Ein KI-Videogenerator erschafft auf der Grundlage einer Texteingabe (oder eines Bildes, oder eines Videos) ein Video – in der Theorie. In der Praxis sieht es schwieriger aus:

- Deine Erwartung: Du gibst einen Prompt ein, und das KI-Tool produziert ein Bewegtbild-Video, also beispielsweise 25 aufeinanderfolgende Bilder je Sekunde, und zwar in Hollywood-Qualität.

- Die Realität: Das klappt aktuell nicht – wenn man als Maßstab einen professionellen Werbespot hat. Denn der hat a) viele Szenen, b) einen konsistenten Look, c) Effekte, d) Einblendungen, e) Packshots und f) natürlich echte Schauspieler oder Characters.

Einige Elemente gehen jedoch mit KI. - Was wird dir als KI-Videogenerator verkauft? Drei Varianten:

- KI-Text-to-Video-Generatoren: Funktionieren noch nicht so richtig gut, aber sind für den Ideation-Prozesse natürlich super. Damit kannst du deine filmischen Ideen, die du im Kopf hast, schnell visualisieren. Das ist genial für Werber, Drehbuchautoren, Regisseure, DOPs (Kameraleute), für die Marktforschung und vieles mehr. So könntest du dir ein Kinofilm-Drehbuch per KI als Video generieren lassen, um vor dem Dreh einen Eindruck einer Endfassung des Films zu erhalten. Prinzipiell kannst du dann den Schnitt schon vorher machen und sparst dir den Dreh von Sachen, die im Schnitt rausgeflogen wären.

“Production Ready”-Qualität funktioniert noch am Ehesten bei Cartoons, oder für einzelne Szenen im Film. - KI-Avatar-Video-Generatoren. Das ist relativ banal, da meist nur Lippen-, Augen- und Kopfbewegungen animiert werden, von Menschen oder 3D-Figürchen. Hinzu kommen Script-Generatoren (auf ChatGPT-Basis) und Voice-Over-Generatoren (Sprachsynthese, oft mit “Voice Clone” Deep Fake Technik, um die eigene Stimme zu klonen. Spooky!).

Ein gängiger Verwendungszweck sind Schulungsvideos: Die Produktion von Videos in vielen Sprachen wird ein Klacks. Die Zielgruppe solcher Videos sind Mitarbeiter (die können sich nicht wehren oder beschweren) oder verzweifelte Kunden, die mit deinem Produkt nicht zurechtkommen (die können sich auch nicht wehren).

Es gibt dabei viele Einschränkungen: Bei einem echt gedrehten Video siehst du echte Menschen, die echte Produkte vorführen. Der KI-“Schauspieler” kann nur einen Text runterlabern. Damit sind die Videos eigentlich bebilderte Podcasts. - KI-Stockvideo-Aussuch-Tools: Das ist sowas wie PowerPoint 2.0, also sagen wir mal “animierte Slides Deluxe”. Mit InVideo AI und (eingeschränkt) InVideo Studio kannst du dir per Prompt ein Script schreiben lassen (oder, besser, du nimmst ein professionelles, durchdachtes Script), und das Tool sucht aus Stock-Libraries passende Video-Teile (und leider auch Fotos) raus und schneidet diese hintereinander. Das ist ziemlich cool, da es das langwierige Raussuchen von Stock Footage massiv beschleunigt.

Über Templates lassen sich sogar Super / Inserts / Bauchbinden automatisch erzeugen.

Doch jetzt kommt auch schon der Schlag in den Nacken: Du hast am Ende nur ein Video aus Stock Footage – uncool. Außerdem ist die KI nicht besonders kreativ beim Aussuchen der Szenen. Das bedeutet, dass das visuelle Storytelling tradiert, langweilig, vorhersehbar und einfach echt oll ist. Damit lockst du niemanden hinter dem Ofen hervor.

- KI-Text-to-Video-Generatoren: Funktionieren noch nicht so richtig gut, aber sind für den Ideation-Prozesse natürlich super. Damit kannst du deine filmischen Ideen, die du im Kopf hast, schnell visualisieren. Das ist genial für Werber, Drehbuchautoren, Regisseure, DOPs (Kameraleute), für die Marktforschung und vieles mehr. So könntest du dir ein Kinofilm-Drehbuch per KI als Video generieren lassen, um vor dem Dreh einen Eindruck einer Endfassung des Films zu erhalten. Prinzipiell kannst du dann den Schnitt schon vorher machen und sparst dir den Dreh von Sachen, die im Schnitt rausgeflogen wären.

KI-Videogenerierung: 4 Tools stelle ich dir vor

1. Runway

Ein kleiner Test mit dem KI-Videogenerator Runway: Ich habe das Tool mit einem von mir KI-generierten Foto (mit Bria erstellt) “gefüttert”, um es animieren zu lassen. Vorgebrieft ist, dass das Foto das “Endframe” ist. Klappt! Das Video sieht echt gut aus, da Runway hier ein Kino-Style Grading drüberlegt.

Noch besser funktioniert es hier, wenn das Bild das “Startframe” sein soll: Das Segelschiff überholt das Frachtschiff, das sieht ziemlich gut aus.

Sehr funky ist bei Runway die KI-Video-to-Video-Generierung: Damit änderst du den Style deines Videos. Sogar Presets sind eingebaut, und damit kannst du Schabernack anstellen. Ein Beispiel ist die “Style Reference” namens “Space”. Das ist jetzt nur ein Auf-die-Schnelle-Versuch ohne eigenen Prompt, aber das Ergebnis ist schon nicht ganz blöd (bis auf die Qualität). Die Idee – ein Schiff überholt das andere Schiff – wurde in die Space-Welt übertragen. Statt Meer gibt es einen Wüstenplaneten, und die Schiffe sehen nach Raumschiffen aus.

Als Inspiration taugt das: Ich sehe in diesem 4-Sekunden-Clip ein “Waterworld”-Remake als Space-Saga, also Madmax mit Space-Wüstenschiffen. Trash? Möglicherweise!

Runway kann noch mehr:

Der Filmprofi denkt bei Videos nicht nur an das Gefilmte, sondern vor allen an die Weiterverarbeitung: Video-Nachbearbeitung, Special Effects / VFX, Color Grading (also die Herstellung eines filmischen Looks), die Retusche, Untertitel etc.

Runway ist hier ziemlich aussichtsreich unterwegs, das könnte sich zum Schweizer Taschenmesser entwickeln.

Nachteile, wie überall: Die Ergebnisse sind nicht immer “Production Ready”, und für kommerzielle Nutzung sollte man auf die Herkunft der Traningsdaten achten – dieses Problem ist dank der Kooperation mit Lionsgate vielleicht bald gelöst.

Was kostet Runway? Das billigste Monatsabo fängt bei 15 Dollar an, und da sind dann ein paar Credits inklusive. Dafür bekommst du in etwa 60 Sekunden KI-Film plus ein wenig Rumgespiele mit den anderen Tools.

Beim KI-Editing werden die Schnittprogramm-Anbieter natürlich nicht schlafen, sondern nachziehen. DaVinci Resolve von BlackMagic hat KI mit drin, unter anderem werden Stimmen erkannt, Texte transkribiert und das Footage automatisch geschnitten. Außerdem kannst du Leute per KI freistellen (Magic Mask) oder per Outpainting Objekte entfernen.

2. Oxolo: die KI-Avatare sind gut

Oxolo bietet an, dass du einfach eine URL einer Website oder einer Landingpage eingibst und daraus dann ein Video erstellt wird – mit KI-Avatar und Sprecher.

Der KI-Avater ist ganz OK, die deutschen Stimmen sind auch in Ordnung.

Das Tool selbst ist allerdings lachhaft: Ich hab’s getestet, und im Video wird das Cookie-Banner der Landingpage vorgelesen. Ay Caramba. Die Texteinblendungen sind grauenhaft. Und der gesamte Inhalt des Videos ist unbenutzbar. Wo soll man da anfangen? Das ist für die Tonne.

Fairerweise muss man sagen: Die Funktion ist einfach nicht ausgereift und mit manueller Nacharbeit bekommt man die Probleme in den Griff.

Die Avatare selbst sind brauchbar, wenn man die rangezoomte Version nimmt. Es gibt auch Avatar-Versionen, bei denen man die Hände sieht, und die bewegen sich erratisch roboterhaft.

Script und Hintergrund sollte man in jedem Fall selbst erstellen bzw. aus Stock-Videos zusammenzuschen. Noch besser ist es vielleicht, den KI-Avatar einfach wegzulassen.

3. HeyGen: Gute Video-Avatare und Integration in Adobe Express

HeyGen ist ganz gut, um KI-Video-Avatar-Videos zu generieren. Es gibt viele Templates fürs Video-Design, die “Figuren” sind gut und die Stimmen sind sogar Dialekttauglich. Im Test-Video habe ich Schweizerdeutsch verwendet, das funktioniert gut! Dialekte sind schwierig, da die Aussprache stark von der Schriftsprache abweicht.

Der erste Teil des Videos ist ein von mir KI-generiertes Foto eines Bärtigen, das durch HeyGen animiert wurde. Das Ergebnis finde ich beachtlich – immerhin ist das die Schmalspur-Free-Version. Mit einem “Studio Avatar” wird die Sache dann ziemlich gut: Nehme ein Green-Screen-Video von deinem Protagonisten auf und lasse daraus einen KI-Avatar rendern. Da bekommste dann deine eigene Urlaubsvertretung… wenn du dann noch ein Conversational Voice AI wie Retell AI dazwischenschiebst und du eine Anbindung an Live-Video hinbekommst, könntest du Video-Meetings von der KI machen lassen während du im Garten in der Sonne liegst…

Tipp: Freigestellte “Menschen” sind als Avatare besser, da man dann den Hintergrund für Videos, Slides, Charts und Super verwenden kann.

HeyGen hat natürlich auch einen GPT Script Writer eingebaut, der das Script schreibt. Wie gut so ein Script für einen geeignet ist, muss man für sich selbst entscheiden. Die Super und den restlichen Kram musst du immer noch selbst machen.

4.1 Invideo AI: KI-Stock-Video-Zusammennagler

Invideo AI solltest du im Auge behalten. Es ist das Text-to-Video-KI-Videogenerierungstool von invideo.io: Du gibst ein kurzes Briefing ein, und InVideo erstellt daraus ein Video aus Stockmaterial. Die (Video-)Quellen sind unter anderem Storyblocks, Shutterstock und iStock. Diese Videos sind als Prototyp / Animatic / Stealomatic geeignet. Um daraus ein voll nutzbares Video zu machen, musst du a) Zeit investieren, b) an die Post Production denken.

Im ersten Schritt gibst du einen Prompt ein, mit dem das Script generiert wird (geht derzeit nicht auf Deutsch). Danach wählst du Zielgruppe (z.B. Führungskräfte), Look & Feel (z.B. Inspiring) und Zielplattform aus (z.B. LinkedIn, YouTube).

Jetzt wird auch schon das Video generiert, mit Bild, Voice Over, Supers und Musik. Bild und Text passen oft zusammen, aber nicht immer.

InVideo Studio hingegen kann Deutsch! Also zumindest kannst du deutsche Voice Over generieren lassen.

Der kleine Button “Edit” ist also extrem wichtig: Dort schraubst du am Script und an den Assets. Videoschnipsel austauschen ist ganz einfach. Das musst du auch, denn InVideo baut gern Stills ein (also Fotos) und nicht ganz passendes Footage.

Eigene Assets, wie Logos, Charts/Stills oder Videosequenzen, baust du in diesem Schritt auch ein.

Das Beispielvideo kannst du dir hier ansehen: https://ai.invideo.io/watch/5m4I8n2GWDG

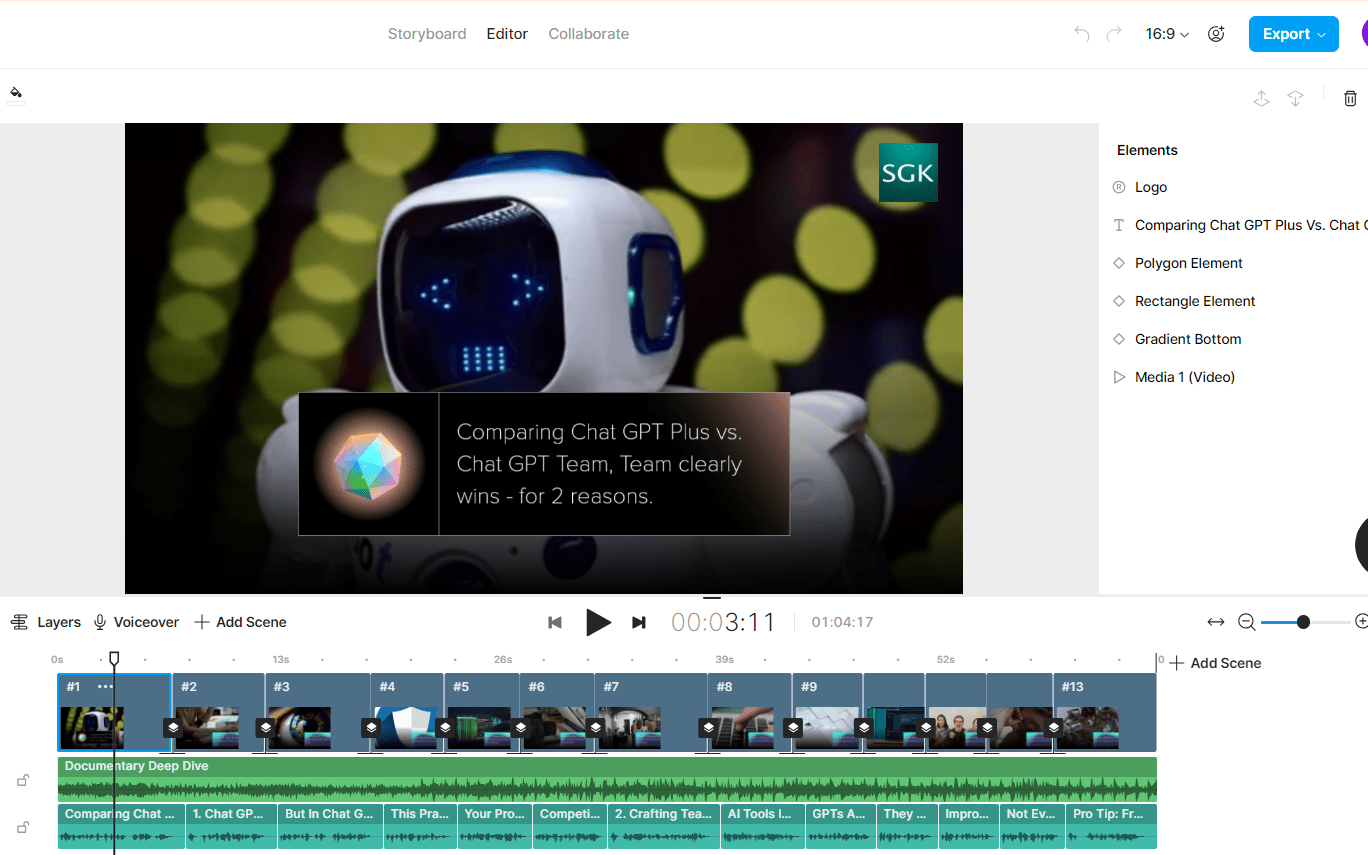

4.2 InVideo Studio

Mit InVideo Studio sieht der Workflow anders aus, und man bekommt tatsächlich verwendbare Ergebnisse. Erst macht man das Script (auch mit KI-Support) und legt ein Template fest, dann sucht das System zum Text und zum Template passend Videos zusammen. Nicht schlecht!

Die einzelnen Szenen kannst du bearbeiten (Logo einfügen, Super ändern, Grading-Vorlage drüberlegen, Video tauschen), dann fügst du ein Voice Over dazu (KI-generiert oder eine Datei von deinem Rechner), und Musik kommt auch drunter. Das Video exportierst du dann, als Download, oder auch als Direkt-Upload bei YouTube (das ist nicht nur wegen möglicher Musik-Rechte ganz praktisch).

Das Beispielvideo auf Englisch zeigt, was auf die Schnelle möglich ist. Die KI-Stimme ist nicht auf Weltklasse-Niveau. Die Stock Videos sind gut, obwohl ich absichtlich auf “Premium” Stock (iStock) verzichtet habe. Ich habe ein paar Fotos dringelassen, um die Foto-Animations-Qualität bewerten zu können. Ist ganz OK! Durch die Grading-Vorlage wird der Look ein bisschen “filmischer”.

Da das Video nur eine Demo ist, habe ich mir Intro, Outro und Feinschliff aller Art gespart.

Ein paar Funktionen vermisse ich, beispielsweise eine halbautomatische “Ich brauche das Video in einer anderen Sprachversion” Funktion.

Ist InVideo kostenlos?

Es gibt quasi zwei “InVideos”: “AI” und “Studio”. InVideo AI ist zum Rumspielen kostenlos, um Testvideos zu erstellen. Die Videos lassen sich sogar exportieren oder per Link teilen. Diese Videos sind allerdings nicht nutzbar, da sie verschiedene Wasserzeichen haben. Die Lizenzbedingungen lassen damit einen realen Einsatz nicht zu, und abgesehen davon sind Videos mit Wasserzeichen superpeinlich. Für InVideo Studio brauchst du für den Export ein Upgrade, du musst also zahlen.

Und wie es sich für strubbelige Cloud-Tools so gehört, fühlen sich “AI” und “Studio” wie getrennte Produkte an – was sie auch sind.

Wie viel kostet InVideo?

Ab 25 Dollar im Monat geht’s für InVideo AI los, InVideo Studio ab 30 Dollar. Der Preis ist ein echter Schnapper, da du für die Videos iStock Footage verwenden kannst. Das ist sonst richtig teuer.

Blöd: Das Abo für Studio gilt nicht für AI und umgekehrt. Du brauchst also zwei Abos. Das kann man sich sparen. Mit Studio fährst du viel besser, da es mehr Kontrolle übers Ergebnis bietet und es vor allem mehrere Sprachen kann.

Ausnahme: Du willst auf die Schnelle Protoypen für Videos auf Englisch machen, dann ist AI besser.

Warum wird Invideo.ai online so gefeiert?

Invideo.ai bietet „Influencern“, Content Creators und Glücksrittern Verkaufsprovisionen. Einige der Jubel-Arien dürften also knallharte Schleichwerbung sein.

Und was ist mit Sora?

Sora ist die (kommende) KI-Video-Generierungs-Schwester von Chat GPT und Dall-E, gehört also zur Open-AI-Familie. Durch die Eingabe eines Briefings in natürlicher Sprache wird ein Video-Generierungsprozess gestartet.

Sora von Open AI funktioniert nach dem „Diffusion“-Prinzip: Es wird, ähnlich zur Bildhauerei, ein Steinklotz genommen (= Rauschen) und nach und nach alles weggekloppt, was nicht nach einer Michelangelo-Statue aussieht. Die Ergebnisse sind dann teilweise funky.

Von Stability AI gibt’s was Vergleichbares, nämlich Stable Video Diffusion (Image-to-Video-Generierung) und Stable Video 3D. “Production quality” hat das alles nicht.

Mehr Magie: Profis ranlassen

Die Online-Schnittprogramme sind der Bedienung ein bisschen nervtötend, weswegen meine Empfehlung gilt:

Buche Profis für deinen Film, die mit Blackmagic Resolve / After Effects oder was auch immer umgehen können. Sonst sieht dein Video nämlich aus wie billig zusammengestückelt.

Und investiere in ein gutes Script. Das kostet nicht viel und ist didaktisch überzeugend.

Die Zukunft von Video in einer Welt mit KI

- Szenario 1: Die für jedermann einfache Möglichkeit zur Erzeugung von Videos wird dafür sorgen, dass das Internet mit Videos überschwemmt werden wird.

- Folge: Es wird immer schwerer, sich mit seinen Videos durchzusetzen.

- Lösung: Du brauchst a) kreativere Video-Ideen (= Storytelling) und b) wird man mehr selbst filmen lassen müssen, um einzigartig zu sein.

- Szenario 2: Die Post Production wird massiv vereinfacht. Stockvideos und eigene Videos lassen sich künftig einfach manipulieren. Im Hintergrund stört ein Karton? Ein Passant läuft durchs Bild? Das eigene Produkt soll eingebaut werden? Diese Tasks wird KI lösen, mit “generative fill”, Inpainting, Outpainting und anderen Techniken.

- Folge: Videos werden durch die Bank professioneller aussehen, und man muss beim Dreh weniger auf Kleinigkeiten achten. Kamera-interne KI-Funktionen werden hinuzukommen und bei der Bildgestaltung helfen. Die aktuellen Android- und iOS-Smartphones gehen ja schon in die Richtung.

- Lösung: Du brauchst kreativere Videos, denn perfekte Videos sind dann keine Kunst mehr. Es wird also eine Raw-/Handmade-/LowFi-Gegenbewegung geben. Ich würde auf ein 8mm-Film-Revival wetten.

Fazit

Mit den KI-Video-Generierungs-Tools Invideo AI und HeyGen ist es möglich, Bewegtbild-Content bzw. KI-Avatare zusammenzuzimmern. Ganz ausgereift ist das alles nicht, aber in jedem Fall kannst du das Bewegtbild-Storyboarding bzw. -Prototyping beschleunigen.

Stelle dir jedoch die Frage, ob deine Marke durch künstliche Menschen und Videos aus der Stock-Kiste hochwertiger als bisher erscheint, oder ob das für die Marke riskant ist. Es kommt einfach auf den Einsatzzweck an: Ein zusätzliches Tutorial-Video mit KI-Avatar ist vielleicht nutzerfreundlicher als eine 100-seitige Anleitung als PDF.

Über den Autor

Stefan Golling, Köln. Seit 2011 Freelance Creative Director, freier Texter, Creative Consultant und Online-Marketing-Berater mit Kunden von Mittelstand bis S&P 500. Erfahrung: 1998 mit Radiowerbung in Stuttgart gestartet, 2000 als Junior-Werbetexter zu Publicis München, 2001 Counterpart Köln, 2002 als Copywriter zu Red Cell Düsseldorf (heißt heute Scholz & Friends), dort ab 2007 Creative Director.

Kontakt aufnehmen

Artikel zu ähnlichen Themen

- Social-Media-Management-Workflow? Mehrsprachig!

- Website-Audit-Planungshilfe

- KI: Machine Learning, Generative KI & RPA als Team

- Prompting aufgeschlüsselt: Vieles ist unsichtbar

- LLMs verstehen: Token und Vektoren als Dashboard

- Claude: Was kann die KI von Anthropic?

- Performance Marketing: Leistung braucht Kreativität

- Marketingberatung: Erst das Rezept, dann ans Werk

- Social Selling: Hallo wer? Oder Ja gern?

- KI-Ethik und EU AI Act: Mitdenken ist Pflicht

- Customer Journey: Das Ziel ist das Ziel

- Chat GPT: Überblick, GPTs nutzen, Alternativen

- Google Gemini: KI mit Riesenhirn

- Statt Online Marketing Agentur: Flexibler mit Freelancern?

- TikTok für Unternehmen: 4 schnelle Tipps

- KI-Videogenerator: Meine Testergebnisse

- KI-Bild generieren: und die Lizenz? Mit Vergleichstest!

- Hugging Chat Assistants: Alternative zu Custom GPTs

- Marketingmaßnahmen als 5-Dimensionen-Modell (mit Chat Bot)

- Hugging Face Spaces: der KI-Abenteuerspielplatz

- Chat GPT: Plus? Nein. Team? Ja. 2 Gründe

- Prompt Engineering: 5 Text-to-Text-Konzepte für Nicht-Nerds & Ausblick

- KI im Marketing: Turbo-Praktikanten und die Zukunft

- KI-Marketing-Tools: 5x gratis ausprobieren

- Inbound-Marketing in Gefahr: dank KI und Chatbots

Artikel zu ähnlichen Themen

- Social-Media-Management-Workflow? Mehrsprachig!

- Website-Audit-Planungshilfe

- KI: Machine Learning, Generative KI & RPA als Team

- Prompting aufgeschlüsselt: Vieles ist unsichtbar

- LLMs verstehen: Token und Vektoren als Dashboard

- Claude: Was kann die KI von Anthropic?

- Performance Marketing: Leistung braucht Kreativität

- Marketingberatung: Erst das Rezept, dann ans Werk

- Social Selling: Hallo wer? Oder Ja gern?

- KI-Ethik und EU AI Act: Mitdenken ist Pflicht

- Customer Journey: Das Ziel ist das Ziel

- Chat GPT: Überblick, GPTs nutzen, Alternativen

- Google Gemini: KI mit Riesenhirn

- Statt Online Marketing Agentur: Flexibler mit Freelancern?

- TikTok für Unternehmen: 4 schnelle Tipps

- KI-Videogenerator: Meine Testergebnisse

- KI-Bild generieren: und die Lizenz? Mit Vergleichstest!

- Hugging Chat Assistants: Alternative zu Custom GPTs

- Marketingmaßnahmen als 5-Dimensionen-Modell (mit Chat Bot)

- Hugging Face Spaces: der KI-Abenteuerspielplatz

- Chat GPT: Plus? Nein. Team? Ja. 2 Gründe

- Prompt Engineering: 5 Text-to-Text-Konzepte für Nicht-Nerds & Ausblick

- KI im Marketing: Turbo-Praktikanten und die Zukunft

- KI-Marketing-Tools: 5x gratis ausprobieren

- Inbound-Marketing in Gefahr: dank KI und Chatbots

FAQ

Was ist ein Animatic?

Ein Animatic ist ein Video, das aus Scribbles und Illustrationen erstellt wird. Es ist damit eine Art animierter Zeichentrickfilm. Entweder werden nur die Illus des Storyboards hintereinandergeschnitten oder manchmal werden auch komplexe Szenen grob animiert. Sinnvoll ist ein Animatic, um das Timing einer Filmsequenz zu testen. Vor allem aber werden Szenenaufbau, Setdesign und Kameraeinstellungen sichtbar. Sinnvoll ist es, ins Animatic Voice Over, Dialoge und Musik einzubauen.

Ein Animatic wird von Profis für Profis erstellt. Filmlaien, sagen wir mal “Leute in Marketingabteilungen mit wenig Filmerfahrung”, kommen mit Animatics nicht gut klar. Das liegt daran, dass man viel Vorstellungskraft braucht: Die Scribbles sind schon mal sehr rough.

Wenn man ein Animatic eines TV-Spots braucht, das im Rahmen von Marktforschung “echten” Endkonsumenten mit minimalem Filmverständnis gezeigt wird, wird der Aufwand erhöht: Die Illus sind dann richtig gut, vielleicht sogar photorealistisch. Als Sprecher nimmt man einen Profi.

Was ist ein Stillomatic?

Ein Stillomatic ist ein Video, das aus Einzelbildern – englisch “Stills” erstellt wird. Wenn man unternehmenseigene Fotos oder Stockbilder benutzt, kann man daraus nicht nur Test-Videos machen, sondern auch “fertige” Videos bauen. Den Diashow-Effekt (kennt noch jemand Dias?) muss man dann als Stilmittel einsetzen.

Ein Stillomatic hat gegenüber dem Animatic den Vorteil, dass die Betrachter nur wenig Abstraktionsvermögen brauchen. Der Nachteil ist, dass man sich auf Fotos beschränken muss – man kann also der Fantasie nicht freien Lauf lassen. Ausnahme: Du nimmt ein Tool zur AI-Bildgenerierung. Etwas tricky wird es dabei, einen einheitlichen Look hinzubekommen. Allein über das Grading, also die Farbkorrektur, klappt das nicht immer. Du musst also Bilder aussuchen, die visuell zusammenpassen. Das schränkt die Auswahl ein.

Was ist ein Stealomatic?

Ein Stealomatic ist ein Video das mit zusammengeklauten – ja, das “steal” steht genau dafür – Videosschnipseln geschnitten wird. Solche Videos kann man nur für interne Zwecke verwenden, sagen wir mal eine kleine Vertriebstagung ohne externe Zeugen oder zur Visualisierung von Storyboards. Manchmal kann man das Videomaterial lizenzieren, dann ist ein legaler Einsatz möglich.

Was ist Stock Footage?

Stock Footage ist Videomaterial, das von professionellen Videografen gedreht wurde. Das Wort Footage kommt aus der englischen Filmsprache: der verfilmte Film wird in der Längenheinheit Fuß gemessen. Dieses Videomaterial findest auf Online-Plattformen: Entweder sind die Videos a) lizenzpflichtig, dann musst sie für einen gewissen Zeitraum lizensieren, b) lizenzfrei, dann kann du die Lizenz einfach so kaufen oder c) kostenfrei, dann musst du weder zahlen noch (je nach Plattform) die Urheber angeben.

Neben “commercial” Stock Footage, das man für Werbung verwenden kann, gibt es noch “editorial only” Footage, das nur für den redaktionellen Einsatz nutzbar ist. Für den Einsatz in Spielfilmen ist (historisches) Editorial Footage meist lizenzierbar.